Kursinhalte

Voreingenommene Daten

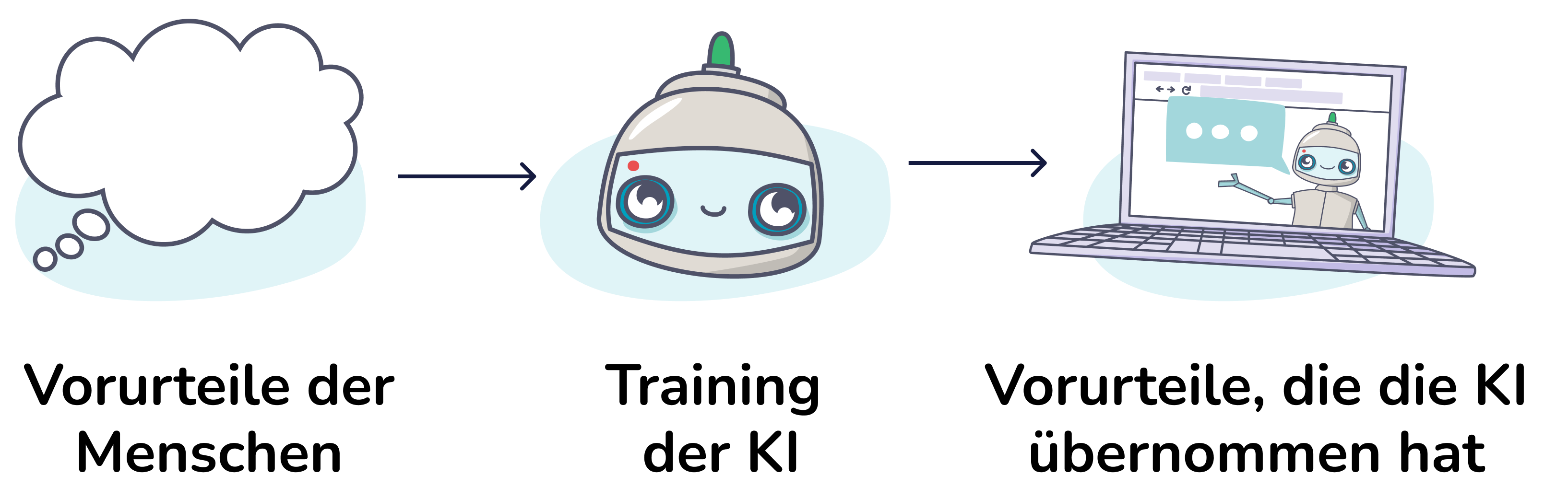

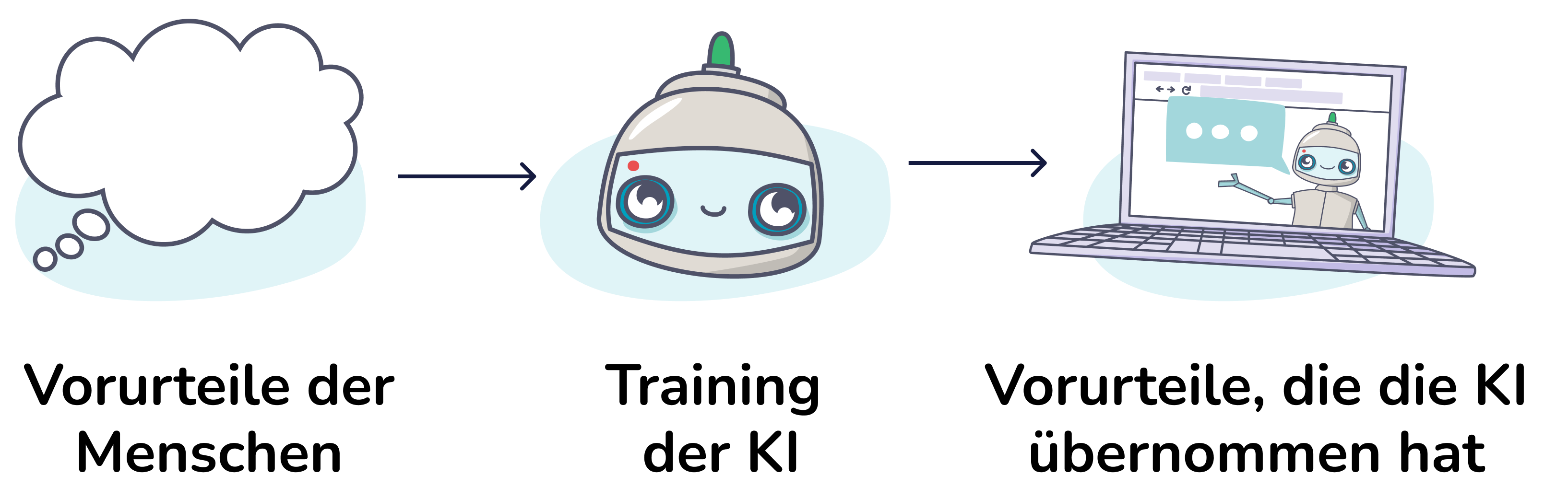

Im letzten Kapitel haben wir gelernt, dass Maschinen aus Daten lernen. Das bedeutet, dass sie auch unsere Vorurteile übernehmen können.

Bevor wir tiefer in das Thema eintauchen, machen wir eine kurze Übung, die zeigt, wie unterschiedlich Perspektiven und Definitionen selbst bei einfachen Alltagsgegenständen sein können.

Prompt: “A photo of a group of nurses in scrubs standing in a hospital hallway. They are all smiling and laughing, and they are wearing name tags that identify them as employees of the hospital.”

Prompt-Übersetzung: „Ein Foto von einer Gruppe von Krankenpflegenden in Kitteln, die in einem Krankenhausflur stehen. Sie alle lächeln und lachen und tragen Namensschilder, die sie als Mitarbeitende des Krankenhauses ausweisen.“

Quelle: https://lexica.art/prompt/3cfe52f9-34d2-4fa0-b5ef-af0e93691ec6

Aber warum ist das so?

Die KI lernt aus den Daten, mit denen sie trainiert wurde – also zum Beispiel aus Millionen von Bildern. Aufgrund der Masse an Daten und anderer Faktoren, wie zum Beispiel die verstärkte Repräsentation von Vorurteilen in Datensätzen, kann es zu dem Ergebnis führen, dass diese Vorurteile von der KI reproduziert werden. So kann es dazu kommen, dass eine KI bestehende Vorurteile verstärkt, anstatt sie abzubauen.

Bevor wir tiefer in das Thema eintauchen, machen wir eine kurze Übung, die zeigt, wie unterschiedlich Perspektiven und Definitionen selbst bei einfachen Alltagsgegenständen sein können.

Ein Beispiel: Generative KI

KI-Werkzeuge zur Bildgenerierung zeigen oft unbewusst gesellschaftliche Vorurteile. Zum Beispiel: Gibt man der KI den Auftrag, ein Bild von Krankenpflegenden zu erstellen, werden überwiegend Frauen gezeigt.Prompt: “A photo of a group of nurses in scrubs standing in a hospital hallway. They are all smiling and laughing, and they are wearing name tags that identify them as employees of the hospital.”

Prompt-Übersetzung: „Ein Foto von einer Gruppe von Krankenpflegenden in Kitteln, die in einem Krankenhausflur stehen. Sie alle lächeln und lachen und tragen Namensschilder, die sie als Mitarbeitende des Krankenhauses ausweisen.“

Quelle: https://lexica.art/prompt/3cfe52f9-34d2-4fa0-b5ef-af0e93691ec6

Aber warum ist das so?

Die KI lernt aus den Daten, mit denen sie trainiert wurde – also zum Beispiel aus Millionen von Bildern. Aufgrund der Masse an Daten und anderer Faktoren, wie zum Beispiel die verstärkte Repräsentation von Vorurteilen in Datensätzen, kann es zu dem Ergebnis führen, dass diese Vorurteile von der KI reproduziert werden. So kann es dazu kommen, dass eine KI bestehende Vorurteile verstärkt, anstatt sie abzubauen.

Und trotzdem neigen wir Menschen oft dazu, den Ergebnissen von KI oder anderen automatisierten Systemen mehr zu vertrauen als menschlichen Entscheidungen. Dieser Effekt wird „Automation Bias“ genannt.

- Verstärken wir unbeabsichtigt bestimmte Muster und Vorurteile?

- Aus welchen Quellen stammen die Daten und bilden sie eine Situation / einen Sachverhalt vollständig ab?

- Wurden manche Gruppen oder Merkmale dabei öfter oder seltener berücksichtigt als andere?

- Gibt es in den Daten historische Verzerrungen, die den Algorithmus beeinflussen könnten?

- Wie können wir sicherstellen, dass immer ausgewogenere Datensätze verwendet werden und dass Menschen und Systeme so zusammenarbeiten, dass keine benachteiligenden oder diskriminierenden Entscheidungen getroffen werden?

Aufgabe

Fallen euch weitere Beispiele ein, bei denen Daten (z. B. von Apps, Webseiten oder sozialen Medien) Vorurteile zeigen oder bestimmte Gruppen benachteiligen?Abschlussbedingungen